燃!好燃的AI芯片盛会,大模型时代国产化希望丛生

芯东西(公众号:aichip001)

作者 | 全球AI芯片峰会

芯东西9月17日报道,今日,2025全球AI芯片峰会在上海举行,来自AI芯片领域的42位产学研专家及创业先锋代表,畅谈对大模型下半场中国AI芯片创新、落地、生存、破局的最新观察与思考。

一如既往,大会将国产AI芯片新老势力、核心生态链企业、投资机构代表汇聚一堂,集中输出技术及产业干货,全景式解构AI芯片热门发展方向。

本届峰会由智一科技旗下智猩猩与芯东西共同举办,以“AI大基建 智芯新世界”为主题,由主论坛+专题论坛+技术研讨会+展览区组成,覆盖大模型AI芯片、架构创新、存算一体、超节点与智算集群技术等前沿议题。AWE同时也是本次峰会的战略合作机构。

值得一提的是,多家AI芯片企业在会上放出猛料。例如,几位资深投资人分享投资AI芯片企业所看重的条件,一家超节点创企成立几个月就融资六七亿,云天励飞正在研发新一代NPU Nova500,华为昇腾将在12月把CANN全量开源,曦望Sunrise下一代芯片的大模型推理性价比对标英伟达Rubin GPU。

在展览区,超摩科技、奎芯科技、特励达力科、Alphawave、芯来科技、Achronix、曦望Sunrise、矩量无限、AWE、晶心科技、芯盟科技等11家展商进行展示。

▲展览区一隅

作为主办方代表,智一科技联合创始人、CEO龚伦常发表致辞。从2018年3月至今,全球AI芯片峰会共邀请了超过180位产学研大咖,分享行业趋势与洞见,已成为AI芯片领域唯一一个持续举办且具有广泛影响力的产业峰会,也是了解国内外AI芯片动态的重要窗口。

▲智一科技联合创始人、CEO龚伦常

龚伦常还预告了将于今年11月底在深圳举办的2025中国具身智能机器人大会,欢迎大家参会交流。

注:本文整理了主论坛与大模型AI芯片专题论坛的精华总结。更多相关报道将在后续发布。

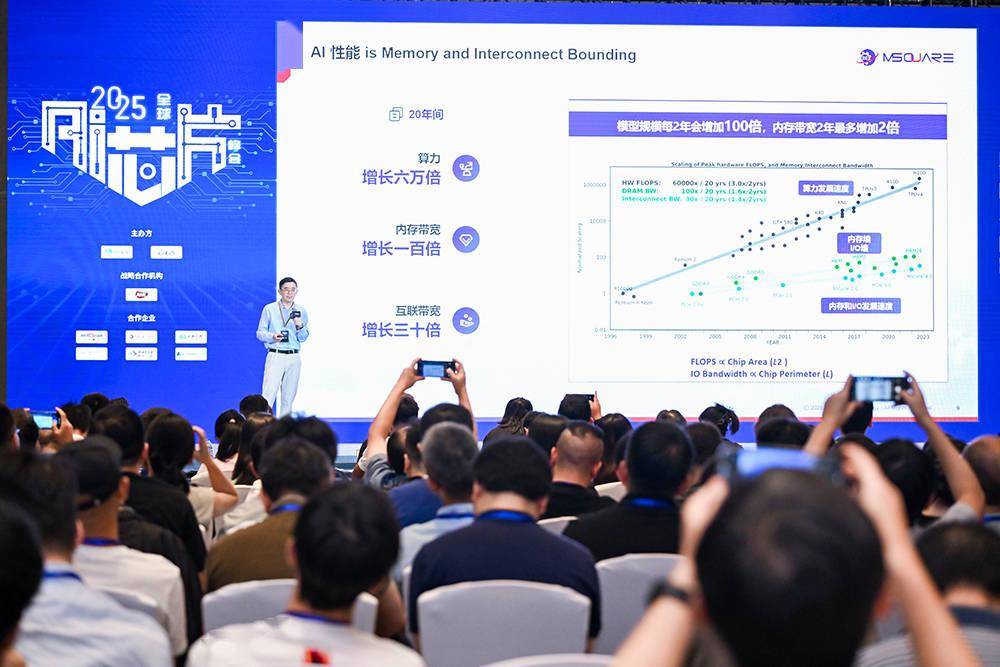

一、IEEE Fellow王中风教授:解读AI芯片三大前沿方向

应对模型规模“超摩尔”增长、传统架构“内存墙”、应用场景日趋多元化三大挑战,中山大学集成电路学院院长、IEEE/AAIA Fellow王中风教授探讨了AI芯片设计的三大前沿方向,为行业的发展提供了宝贵的见解和指导。

一是模型驱动的高效芯片设计,在模型尺寸增长的趋势下,让硬件深度适配AI模型特性,而非让模型发展受限于硬件资源。

王中风教授团队提出的Transformer硬件加速架构设计工作,是首个完整解决Attention计算加速挑战的方案,获得了IEEE 2020年片上系统年会(SOCC)最佳论文奖;N:M稀疏Transformer推理加速框架,可快速实现任意N:M稀疏比例的Transformer模型开发和硬件部署,同时能保持精度稳定;粗粒度-细粒度混合精度量化,搭配专用多核加速器来处理差异计算,能够实现更灵活的调度。

二是应用驱动的AI芯片创新,注重模型的落地与应用,兼顾能效和灵活性的探索。

架构创新没有唯一解,只有更合适的解。结合可重构硬件架构(动态适配不同算法需求)、领域专用架构(在垂直场景实现超过通用架构的能效)、Chiplet等先进封装技术(提高设计灵活性、降低成本、缩短上市周期),以应用驱动为核心的AI芯片设计,将是未来值得重点探索的研究方向。

三是基于存算一体的芯片设计,从存算架构根源降低能耗,平衡性能与功耗。

存算一体架构是芯片设计范式转移的一个重要方向。数字存算架构的优势是高精度、高稳定性、生态更成熟,但存在高能耗、高硬件开销、低存储密度等问题;模拟存算架构具有低能耗、高存储密度、低硬件开销等优势,但精度较低、对工艺要求高、生态不成熟。王中风教授团队研究的基于SRAM的数字存内计算架构大模型加速器,支持多种数据精度,相比于传统冯诺依曼架构,能效比可提升数十倍。

上述三条路径并非孤立,而是相互支撑,共同推动AI芯片从“通用适配”走向“精准定制”。

▲中山大学集成电路学院院长、IEEE/AAIA Fellow王中风教授

王中风教授总结说,当前AI芯片发展呈现三大关键趋势:一是从通用计算走向领域专用的“专用化”,二是算法与软硬件共同进化的“协同化”,三是通过新型计算打破性能瓶颈的“一体化”。

以AI计算专用架构SRDA(系统级极简可重构数据流)为例,通过分布式3D内存控制技术、可重构数据流计算架构、系统级精简软硬件融合设计等创新,在大模型智算场景可以大幅提升AI算力利用率与性能,驱使未来基于国产工艺的AI算力芯片也可以实现不亚于国外更先进工艺制程的GPGPU性能。

下一代计算范式的发展,首先是软件、算法、硬件的共生,实现全环节协同进化;其次是实现无处不在、高效且可信的智能计算,在云端实现支持AGI训练的巨型超算系统,在边缘实现自主机器人的实时决策大脑,在端侧实现超低功耗的Always-On感知芯片。

此外,高效支持智能计算,还需要促进新兴技术融合,实现光子计算、量子计算、AI芯片的潜在结合。

王中风教授呼吁开放标准,推动接口、互联、指令集等的开放,降低创新门槛;注意产学研深度合作,共同攻克量智融合、存算一体、新材料、新工艺、新器件等领域的技术难题;注重人才培养,培养兼具算法、架构、底层电路及软件开发等技能的交叉型人才。

二、高端对话:大模型下半场引爆国产算力,AI芯片IPO潮将更具想象

高端对话以《⼤模型下半场,中国AI芯⽚的破局与突围》为主题,由智一科技联合创始人、智车芯产媒矩阵总编辑张国仁主持,和利资本合伙⼈王馥宇、普华资本管理合伙⼈蒋纯、BV百度风投董事总经理刘⽔、IO资本创始合伙⼈赵占祥四位嘉宾进行分享。

张国仁谈道,大模型的下半场不仅是技术竞赛,更是生态竞争,期待中国即将诞生“芯片+场景+算法”的垂直整合者,出现更多的单项冠军。

▲智一科技联合创始人、智车芯产媒矩阵总编辑张国仁

1、DeepSeek扩大算力池后,投资AI芯片企业看什么?

王馥宇认为,DeepSeek的出现意味着中国出现了“Leading Customer”,好的科技公司会向芯片公司提出需求。蒋纯进一步补充道,DeepSeek最大的意义是让中国有了一套自有大模型体系,让国产芯片有了用武之地。

这些资深投资人会倾向于投资什么样的AI芯片团队?几位投资人均看重企业的技术路线是否收敛。

赵占祥尤其关注技术路线是否有提升及创新。刘水提到百度风投不单纯以商业化衡量项目价值。蒋纯说:“小孩子才做选择,成年人我都要。”他表示成熟技术和创新技术都在投资。王馥宇将市场分为两类,一类是相对确定的市场,考验团队的积累和执行力,第二类是靠技术驱动市场发展。

展望芯片企业的未来机遇,蒋纯认为,碳基文明被硅基文明取代之前,算力的市场机会看不到头,市场前景无穷大,现在的技术体系并不是终局。

2、一家超节点创企,成立几个月融资六七亿

王馥宇称,很多大厂同样在构建非全家桶方式的网络架构,未来百花齐放,企业要保持开发、敏感。

在蒋纯看来,对中国企业面临的现实情况而言,“小米加步枪”的scale out路线和超节点所代表的scale up路线至少是同样重要。

赵占祥透露,IO资本最近在看的一个超节点创业公司,成立几个月就融资六七亿,但在超节点机遇背后,网络的可靠性、故障率要求仍面临挑战。

BV百度风投曾投资不少具身智能企业。据刘水分享,具身智能是个新兴赛道,芯片作为核心硬件支撑,目前还在迭代期,真正能完美匹配各类复杂物理交互场景的成熟芯片产品,行业内仍在探索。

现阶段,很多企业选择x86 CPU加AI芯片的组合来搭建基础算力平台,这是行业在技术演进过程中非常自然的过渡性选择,能快速验证产品逻辑、跑通初步场景。

而这种 “过渡性” 也正是产业的机会所在——未来无论是更适配具身特性的专用芯片研发,还是基于现有硬件的算力效率优化,只要能解决实际场景中的痛点,就是产业发展的机会点。

3、寒武纪一度登顶A股,“寄托了全村人的希望”

几位投资人虽然主要看一级市场,但也聊到对二级市场的观察。他们普遍认为,接下来要IPO的AI芯片公司会比登陆2019年科创板的那批国产替代概念芯片公司更有想象力。

今年,寒武纪一度超越贵州茅台登顶A股“股王”。在蒋纯看来,寒武纪的暴涨背后可能“寄托了全村人的希望”。与上一波芯片企业上市潮相比,当时国产替代概念市场有限,但现在AI市场的需求是无限的。

刘水补充说,AI需求正为计算基础设施建设注入强劲动力。当前,不少国产芯片企业积极推进IPO进程,这本身是行业加速成长的体现——借助资本市场的力量,企业能更好地投入研发、扩充产能,为技术突破和规模化交付奠定基础。

不过,上市只是发展的新起点,最终能否站稳市场,关键仍在于技术的成熟度、产能的稳定供给以及客户的深度认可。

从长远来看,企业需要以持续的技术创新和扎实的商业化能力,真正实现产业价值与市场价值的同步兑现。

三、瞄准大模型高效推理,做好生态开源开放

面向持续爆发的大模型推理需求,如何在芯片架构、开源开放、高速互连、超节点等方向探索创新?

在上午主论坛期间,来自云天励飞、华为昇腾、行云集成电路、奎芯科技、探微芯联、新华三的产业嘉宾分别发表主题演讲,分享了他们的观察与思考。

1、云天励飞陈宁:国产AI推理芯片迎历史性机遇

云天励飞董事长兼CEO陈宁谈道,在“政策+需求”双重驱动下,国产AI推理芯片正迎来绝佳发展机遇。根据灼识咨询报告,中国NPU市场规模短期预计新增规模339.3亿元,长期预计新增规模1092亿元。

高效Token生成是衡量推理芯片性价比的关键指标。11年来,云天励飞已研发五代NPU,打造相关指令集、专用算子、存算一体架构、低比特混合量化等芯片硬件技术。其“算力积木”架构是基于国产工艺的D2D Chiplet & C2C Mesh大模型推理架构,具有可扩展性强、灵活性强、实时性高等特点。

云天励飞提供“深穹”、“深界”、“深擎”三大AI推理芯片系列,分别面向大模型推理算力中心/超节点/一体机/加速卡、边缘网关/边缘盒子/家庭主机、及机器人/无人机/无人车等AI推理等应用。

目前,云天励飞正在研发新一代NPU Nova500,并基于Nova500推出多款性能更强的AI推理芯片。

▲云天励飞董事长兼CEO陈宁

2、华为昇腾王晓雷:公布全面开源的三个关键节点

华为昇腾处理器产品总经理王晓雷谈道,英伟达的软件开发人员是硬件的两倍,我们作为生态的后来者,要做好开源开放,跟客户与伙伴一起,把芯片和解决方案做得更好。

芯片方案多种多样,如何把它用好,是一件非常复杂的事情。

AI计算领域,矩阵执行过程需要保证数据到位,而整个数据搬移过程是计算优化的核心。处理器跟底软团队需要与算法和业务专家联合优化,才能发挥出处理器的高性能。

王晓雷现场公布了昇腾未来进一步全面开源的关键节点,包括9月30日算子库全部开源、12月30日CANN全量开源、2026年起解决方案配套产品上市即开源。

▲华为昇腾处理器产品总经理王晓雷

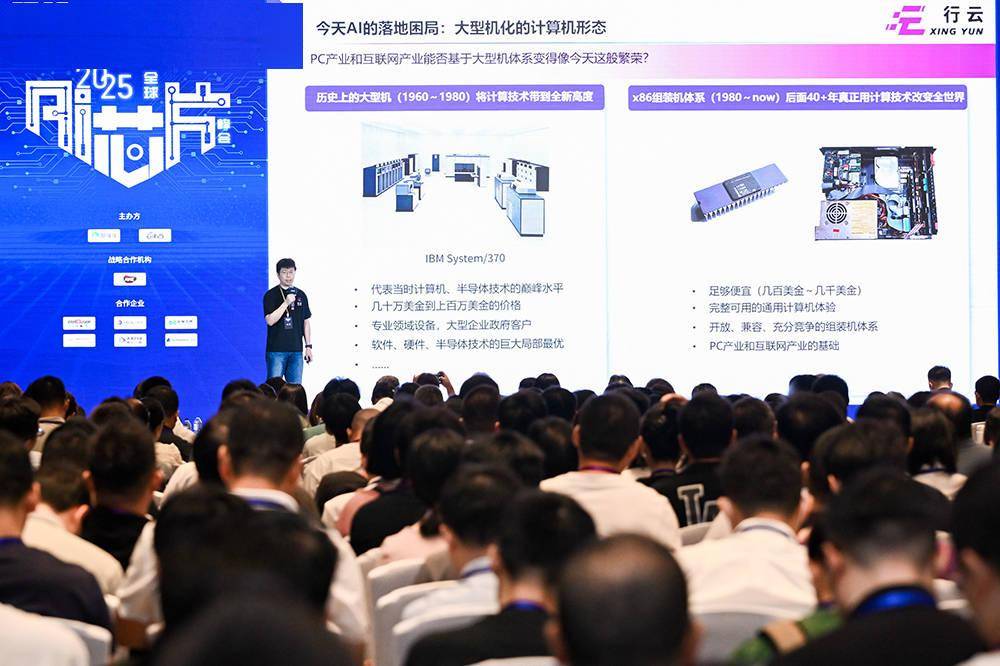

3、⾏云集成电路季宇:10万元跑满血版DeepSeek

⾏云集成电路创始⼈&CEO季宇抛出一个问题:谁困住了AI产业?

他的答案是大型机投资回报率。超节点化、大型机化的成本门槛巨大,但随着大模型内存需求接近DDR/LPDDR的甜点,高质量模型的硬件系统平民化曙光已现。

其概念原型产品大模型一体机“褐蚁”采用5090级算力+TB级高带宽DDR5,能以10万元成本运行DeepSeek R1/V3 671B FP8,对话速度超过20TPS,20K上下文prefill在18秒以内。

集群概念验证方案“蚁群”可将超过40台“褐蚁”机器组合作为decode节点,prefill节点采用4根SSD替代DDR,总成本为300万~500万元,以约1~2台8卡超算的价格,实现20倍于1~2台超算的并发能力,提供接近DeepSeek公有云的性价比。

行云希望通过其原型概念产品,呈现DDR/Flash满足大模型推理需求的潜力,并通过芯片产品,将顶配大模型的硬件成本降低到万元甚至千元级价位,推动AI普惠。

▲⾏云集成电路创始⼈&CEO季宇

4、奎芯科技唐睿:Chiplet将加快国产芯片研发

当前AI革命与过往互联网产业有明显差异,利润高度向硬件环节倾斜。奎芯科技联合创始⼈兼副总裁唐睿谈道,随着模型尺寸不断变大,算力需求飙升,为了争夺AGI领域的胜利,科技企业的CAPEX大幅增长且逐渐取代OPEX成为主流趋势。

AI领域存在芯片设计周期远跟不上算力及模型发展需求的矛盾。在唐睿看来,基于Chiplet的设计能加快芯片研发迭代。

2021年-2030年处理器预计研发项目数量年化增长约9%,但基于Chiplet的设计年化增长率高达44%,预计2030年占比超一半。

对此,奎芯打造了基于UCle标准接口IP的国产化完整解决方案,研发了两代UCle IP,第一代为16GT/s,第二代为32GT/s,且在标准封装实现。这些IP具有高性能、低功耗、灵活性等优势,能为芯片快速迭代提供支持。

▲奎芯科技联合创始⼈兼副总裁唐睿

5、探微芯联刘学:国产超节点如何实现异构互联?

探微芯联创始人、清华⼤学类脑计算研究中心刘学分享说,类脑计算与AI同源异流,天生具备超大规模计算系统的通信基因,与智算超节点的发展趋势十分吻合。

探微将类脑集群技术迁移至GPU智算平台,打造面向AI芯片的Scale-up完整互联方案,实现了覆盖通信协议、交换芯片/网内计算、软件栈/集合通信库、RAS机制与可维护机制、路由算法、超节点平台、性能建模和异构互联等关键技术。

不过,刘学认为,超节点通信不只是技术堆叠。通信协议具有较强生态属性,需要广泛的应用场景和生态支持才能推广。

从类脑集群体系结构的大量工程经验积累,到探微通信互联关键技术的不断迭代,探微方案实现从底层到高层的计算和通信的全方位打通,能够为智算超节点生态伙伴提供Scale-up通信协议系统级解决方案、异构融合及智算超节点万卡集群工程方案。

▲探微芯联创始人、清华⼤学类脑计算研究中心刘学

6、新华三刘善⾼:超节点是AI系统工程巅峰

新华三集团AI服务器产品线研发部总监刘善⾼谈道,大模型技术趋势给算力基础设施带来了算力墙、显存墙、通信墙等挑战,打造AI超节点成为必然趋势。

这需要异构计算协同优化、高速互联网络、精密结构设计等基础设施的深度集成,对软硬协同要求高,是AI系统工程的巅峰。

新华三设计了两款超节点产品:整机柜超节点H3C UniPoD S80000和灵活部署超节点H3C UniPoD F80000。

S80000实现柜内卡间全互联通信,互联带宽提升8倍,单机柜训练性能相较于单节点最高可提升10倍,单卡推理效率提升13倍;F80000基于传统AI服务器即可灵活扩展Scale-up网络,能够实现MoE大规模训练性能提升35%以上。

未来,AI加速卡将更加百花齐放,高带宽低延迟的卡间高速互联网络也将是必然趋势。

▲新华三集团AI服务器产品线研发部总监刘善⾼

四、数据流、低精度、稀疏化、全国产、Chiplet,AI芯片走向多路创新

在下午的大模型AI芯片专题论坛上,上海交通大学计算机学院教授、上海期智研究院PI冷静文分享了数据流体系架构如何成为新一代的大模型加速引擎。

随后,来自曦望Sunrise、爱芯元智、墨芯人工智能、江原科技、迈特芯、智源研究院、北极雄芯、Alphawave的产业嘉宾分别发表主题演讲,分享创新的技术路径与最新进展。

1、上海交通大学冷静⽂教授:数据流能提高大模型推理效率

上海交通大学计算机学院教授、上海期智研究院PI冷静文认为,数据流体系架构是大模型高效执行研究的重要方向,它通过数值压缩与计算流调度的优化,提升推理性能。

低位宽数值类型可显著降低存储开销,提高计算效率;而向量量化有望帮助大模型突破4bit的表示极限。冷静⽂教授团队研发了面向多元素量化的计算引擎VQ-LLM,通过三级缓存机制和以码本为中心的计算流程优化,实现性能与精度的双重提升。

新一代GPU架构正在逐渐DSA化,编程难度不断增加。其团队已经在探索一种“Kernel Free”的编程模型、用“Register Pooling”降低共享内存带来的开销,并使用动态并行机制,最终形成基于代码块的数据流抽象机模型。项目成果未来将开源发布。

▲上海交通大学计算机学院教授、上海期智研究院PI冷静文

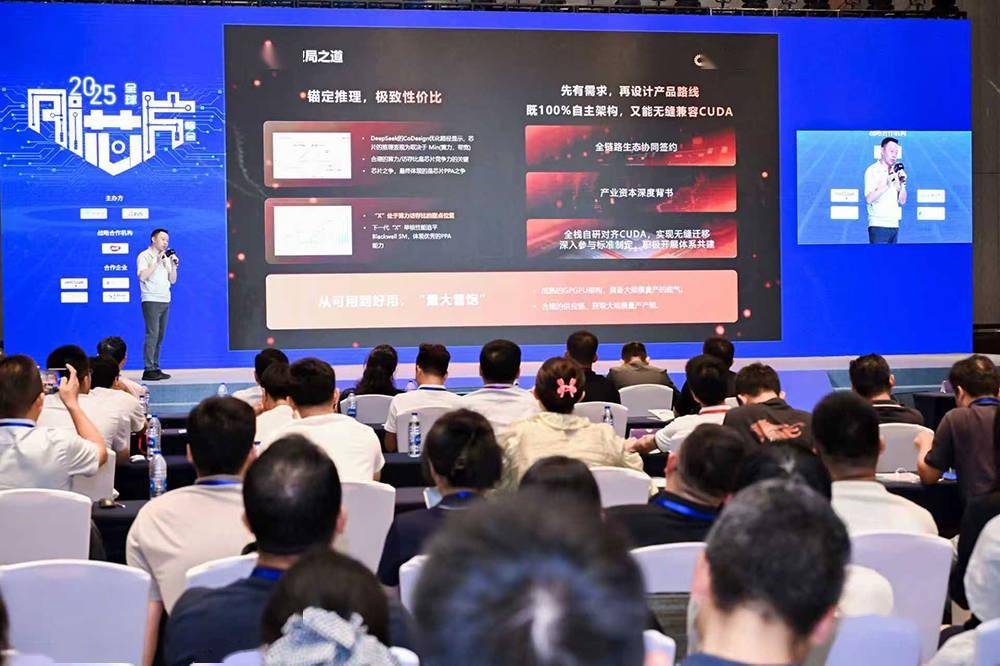

2、曦望陈博宇:国产AI芯片破局,极致推理目标1分钱/百万Token

曦望Sunrise研发副总裁陈博宇认为,大模型发展进入下半场,云端训练算力向高效推理倾斜。AI芯片高效推理是一场长期价值竞赛,降成本、降能耗,性价比的洼地亟待填平。

曦望的下一代芯片采用单芯片高配比低精度计算单元,大模型推理性价比对标英伟达Rubin GPU。

在主流测试集中,NVFP4精度下运行DeepSeek-R1的表现已接近FP8,低精度数据格式能显著扩大数据吞吐,提升推理效率,从而降低每Token成本。

曦望芯片软件生态通用性良好。算子库、工具链、通信库均为全栈自研,主体功能模块与CUDA对齐,支持各类主流开源模型的推理部署,支持CUDA代码无缝迁移和工作。

曦望芯片的应用形态分为一体机和超节点,是Scale-up/Scale-out互联架构原生支持超节点产品。超节点支持PD分离和大EP部署、All-to-All互联、面向千亿级或万亿级参数的多模态大模型推理。

▲曦望Sunrise研发副总裁陈博宇

3、爱芯元智刘建伟:AI应用(大模型)需要重新设计原生AI芯片

爱芯元智联合创始⼈、副总裁刘建伟分享道,过去端侧AI芯片主要跑传统CNN模型,场景明确,大模型的兴起则提升了AI上限,应用场景更广泛,有望引发成本驱动型生产力革命。

在他看来,当AI程序规模足够大时,现有运行架构不是最高效的,值得重新设计适合跑AI程序的原生处理器。

端侧和边侧长期受成本、功耗刚性约束,对高能效比AI处理器需求迫切。这驱使爱芯元智选择从端侧和边缘侧入手做AI基建。

设计原生AI处理器,需关注算子指令集和数据流DSA架构,两者相辅相成。采用可编程数据流微架构可提升能效比。异构多核处理器要保证由硬件来调度,以降低客户开发与使用成本。

爱芯元智已打造了从工具链到芯片的完整软硬件体系,推动构建边缘智能共同体。

▲爱芯元智联合创始⼈、副总裁刘建伟

4、墨芯人工智能曾昭凤:稀疏化让AI计算“更聪明”

墨芯人工智能解决方案总监曾昭凤谈道,传统硬件架构面临性能提升困境,通过软硬一体方案来解决算力瓶颈已是业内公认的发展方向,稀疏化有望成为破解算力瓶颈的突破口。

稀疏计算是一种“更聪明”的AI计算方式,如人类大脑一般,仅启动计算所必需的神经元,减少冗余重复,提升有效性能。

基于这一认知,墨芯提出了“权重稀疏化+激活稀疏化”的双稀疏技术,在相同硬件资源下实现高达32倍的稀疏率,并协同设计了配套的软件方案。

从算法与软件出发,墨芯打造了相应的硬件与架构,开发的计算卡已能在云端推理场景中加速CV、NLP及知识图谱等多类任务。

▲墨芯人工智能解决方案总监曾昭凤

5、江原科技王永栋:构建全国产化AI芯片产业链

江原科技已构建贯通EDA工具、芯片IP、芯片设计、芯片制造、封装测试的全国产化AI芯片产业链。

江原科技联合创始⼈兼CTO王永栋认为,全国产路线已经成为行业共识,核心挑战集中在工艺和生态上。他从工艺、架构、生态层面探讨了国产芯片的突围路径。

工艺维度,国内AI芯片企业唯一的道路就是拥抱全国产,具体路径包括基于国内工艺特点进行协同优化、系统集成创新。

架构维度,需要向AI定制倾斜,通过拆解AI算法将其中占比高、对效率影响大的部分进行硬件优化。

生态维度,从降低客户使用门槛、发挥本土化优势打造性能长板、拥抱开源切入。

▲江原科技联合创始⼈兼CTO王永栋

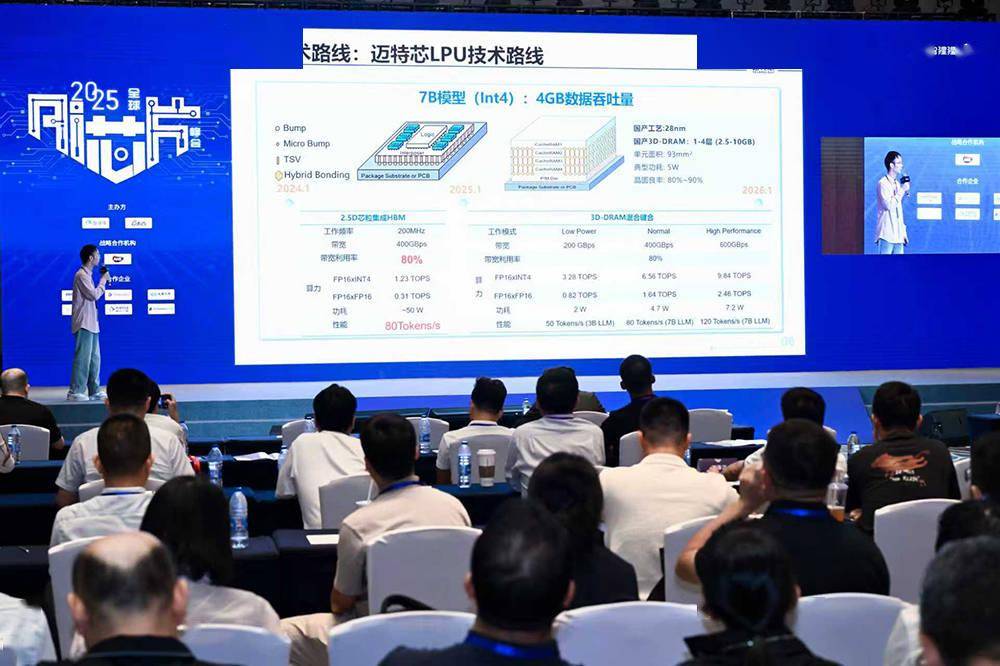

6、迈特芯李凯:突破端侧大模型芯片三个关键痛点

在迈特芯主任工程师李凯看来,端侧AI场景正从“离身智能”向“具身智能”进化,这离不开端侧芯片的支持。端侧大模型芯片(LPU)需要满足低功耗、高token数、低成本,这正是痛点所在。

迈特芯LPU采用的3D-DRAM解决方案可大幅提升带宽,以满足端侧大模型需求。该方案采用了针对大模型算子优化的DSA设计和自研立方脉动阵列架构,基于多项技术优化,实现计算利用率和内存带宽利用率最大化。

演示中,基于迈特芯LPU推理卡可实现大语言模型端到端部署,带宽利用率75%、性能75tokens/s,性能和能效达到国际领先水平。

迈特芯针对泛端侧大模型硬件产品、端侧大模型硬件产品和推理一体机三类场景布局产品,三个市场的总空间可达万亿级。

▲迈特芯主任工程师李凯

7、智源研究院郑杨:统一编译器给OpenAI Triton语言补短板

北京智源⼈⼯智能研究院AI编译器专家郑杨分享说,OpenAI的Triton语言已成为业内公认的、继CUDA后第二大流行的AI算子开发语言,但其也有明显弱势:需要在开发效率和性能之间权衡,跨芯片的可移植性和性能不足,治理与生态面临局限性,以及版本分散等。

为此,智源构建了面向多元AI芯片的统一编译器——FlagTree。

FlagTree基于硬件感知进行了编译指导优化,允许程序员通过注释嵌入硬件优化提示flagtree_hints,具有使用成本低、生态兼容好、可移植性强等特点。

同时,该编译器在C++运行时进行了优化,提供从C++调用Triton内核的方法,从而节省Wrapper耗时,整体降低80%以上,与CUDA接近。

▲北京智源⼈⼯智能研究院AI编译器专家郑杨

8、北极雄芯徐涛:大模型推理落地有效降本迫在眉睫

截至2025年6月,中国日均tokens消耗量突破30万亿,比2024年增长300+倍,且依然处于高速增长期。而大模型应用商业化闭环任重道远,一方面C段订阅付费较难,B端API调用收费与美国相比有数量级的差距,另一方面国内算力成本并不优于美国。

北极雄芯联创、副总裁徐涛谈道,当前中国大模型应用落地商业化,解决成本问题至关重要。而受制于各类制裁,面对高速增长的算力、存储容量、内存带宽的“不可兼得三角”,国内上下游企业亟需共同开展架构创新。

在云端推理场景,北极雄芯将在近期推出面向Decode环节的专用加速方案,通过Chiplet+3D堆叠的近存计算技术大幅降低推理成本至少一个数量级,相比主流GPU芯片提升10倍以上性价比。

在端侧AI领域,北极雄芯的启明935系列芯粒通过Chiplet灵活组合应用,为主机厂提供AI Box、舱驾一体、高阶智驾等不同挡次应用的解决方案。

▲北极雄芯联创、副总裁徐涛

9、Alphawave邓泽群:高速连接市场猛增,Chiplet是变革路径

Alphawave战略客户销售经理邓泽群谈道,高速连接的市场规模2023年接近100亿美元,预计2026年接近180亿美元,年复合增长率达到20%。

这背后的推动力就是数据中心建设,其对数据的传输、存储、处理需求爆炸,数据带宽每2~3年翻一倍。

生成式AI正在重新定义计算和连接。他预测ChatGPT背后下一代模型的参数规模或达到百万亿级别,促使云服务商建设更高规格的数据中心。

邓泽群认为,新计算技术的变革路径是Chiplet,以及为云服务商进行定制,以满足大语言模型的需求。

伴随AI产业发展,Alphawave的业务体系已经从IP供应扩展到高速连接技术的垂直集成方案。

▲Alphawave战略客户销售经理邓泽群

结语:国产AI芯片掀开落地新篇章

8年来,智东西、芯东西持续对AI芯片全产业链进行追踪报道,见证了AI芯片产业及智能革命浪潮的发展,以及许多AI芯片团队的厚积薄发。

多个知名市场调研机构的数据显示,2024年中国AI芯片出货量显著提升,华为昇腾、阿里平头哥、昆仑芯、寒武纪、摩尔线程、燧原科技、中昊芯英、壁仞科技、沐曦股份、太初元碁等企业的AI芯片均已走向量产交付,并在性能方面缩短与国际先进水平的差距。庞大的国内AI基建市场,正向国产AI芯片敞开大门。

与此同时,国产AI芯片正迎来政策红利期。今年8月,国务院印发《关于深入实施“人工智能+”行动的意见》,在强化基础支撑能力方面,提到强化智能算力统筹,支持AI芯片攻坚创新与使能软件生态培育,加快超大规模智算集群技术突破和工程落地。

在AI产业趋势、地缘博弈等复杂因素的影响下,AI芯片自主可控势在必行,国产模型与国产芯片的适配有望进一步增强,AI芯片及算力基础设施技术仍有巨大的创新空间和市场前景。